A revolução da IA generativa chegou.

Você está pronto? Nós estamos.

Durante anos, a inteligência artificial (IA) e o aprendizado de máquina (ML) remodelaram os setores, capacitaram vidas e resolveram problemas globais complexos. Essas forças transformadoras, anteriormente identificadas como HPC (computação de alto desempenho), impulsionaram as transformações digitais em organizações de todos os portes, aumentando a produtividade, a eficiência e a capacidade de resolução de problemas.

O surgimento de modelos de IA generativa (GenAI) altamente inovadores, alimentados pela aprendizagem profunda e pelas redes neurais, está revolucionando ainda mais o jogo. O aumento do uso desses aplicativos de ML e GenAI com uso intensivo de dados e computação está colocando demandas sem precedentes na infraestrutura do data center, exigindo transmissão de dados confiável de alta largura de banda e baixa latência, densidades de cabeamento e energia de rack significativamente maiores e métodos avançados de resfriamento.

A IA avançada exige que o design do data center seja repensado

À medida que os data centers se preparam para a GenAI, os usuários precisam de soluções de infraestrutura de rede inovadoras e robustas que os ajudem a projetar, implantar e dimensionar facilmente malhas de rede de back-end, front-end e armazenamento para ambientes complexos de IA de computação de alto desempenho (HPC).

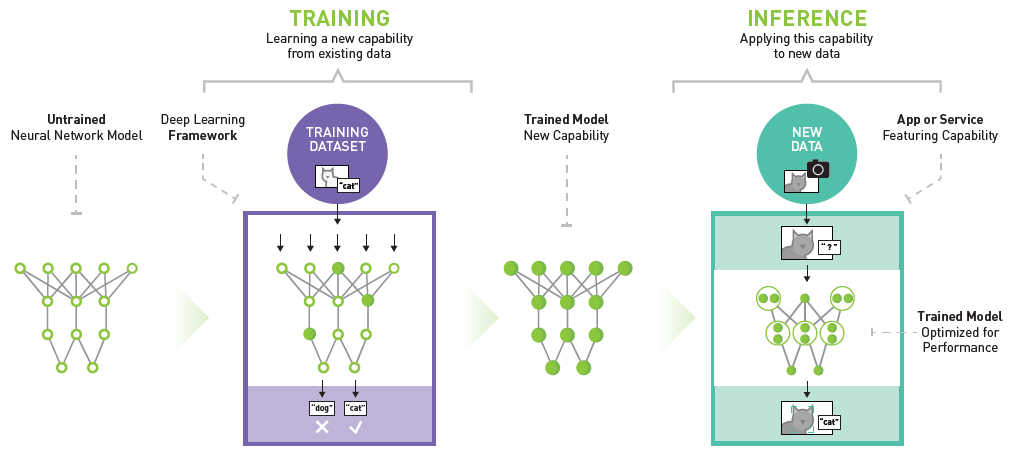

Exemplo da plataforma de inferência de aprendizado profundo da NVIDIA

Os modelos acelerados de GenAI e ML consistem em treinamento (aprendizado de novos recursos) e inferência (aplicação dos recursos a novos dados). Essas redes neurais e de aprendizagem profunda imitam a arquitetura e a função do cérebro humano para aprender e gerar conteúdo novo e original com base na análise de padrões, nuances e características em conjuntos de dados maciços e complexos. Os modelos de linguagem grande (LLM), como o ChatGPT e o Google Bard, são exemplos desses modelos de GenAI treinados em grandes quantidades de dados para entender e gerar respostas de linguagem plausíveis. As CPUs de uso geral que executam operações de controle e de entrada/saída em sequência não conseguem extrair com eficácia grandes quantidades de dados em paralelo de várias fontes e processá-los com rapidez suficiente.

Portanto, os modelos acelerados de ML e GenAI dependem de unidades de processamento gráfico (GPUs) que usam processamento paralelo acelerado para executar milhares de cálculos de alto rendimento simultaneamente. A capacidade de computação de um único servidor baseado em GPU pode corresponder ao desempenho de dezenas de servidores tradicionais baseados em CPU!

Consultor de soluções NVIDIA

Siemon Anuncia soluções de patching óptico para redes GenAI usando computação acelerada NVIDIA.

TechTalk sob demanda: Qual é o impacto da IA generativa em sua infraestrutura?

Nossos especialistas em GenAI fornecem o esclarecimento necessário sobre esse assunto em rápida mudança, apresentando exemplos demonstráveis de como adaptar seus projetos de arquitetura de rede para melhor atender aos requisitos de treinamento e inferência.

Leia maisSiemon está pronto para IA

Siemon está na fronteira da revolução da GenAI e, por meio da colaboração com nossos clientes e parceiros, que estão na vanguarda do fornecimento dessas tecnologias, desenvolvemos uma variedade de soluções prontas para IA de última geração que estão prontas para dar suporte às suas implementações.

Arquiteturas e aplicativos emergentes de rede de data center de IA

Explore as soluções de ponta prontas para IA da Siemon, projetadas para arquiteturas de data center emergentes. Descubra o cabeamento e a conectividade de alto desempenho para cargas de trabalho contínuas de IA e HPC.

Leia mais